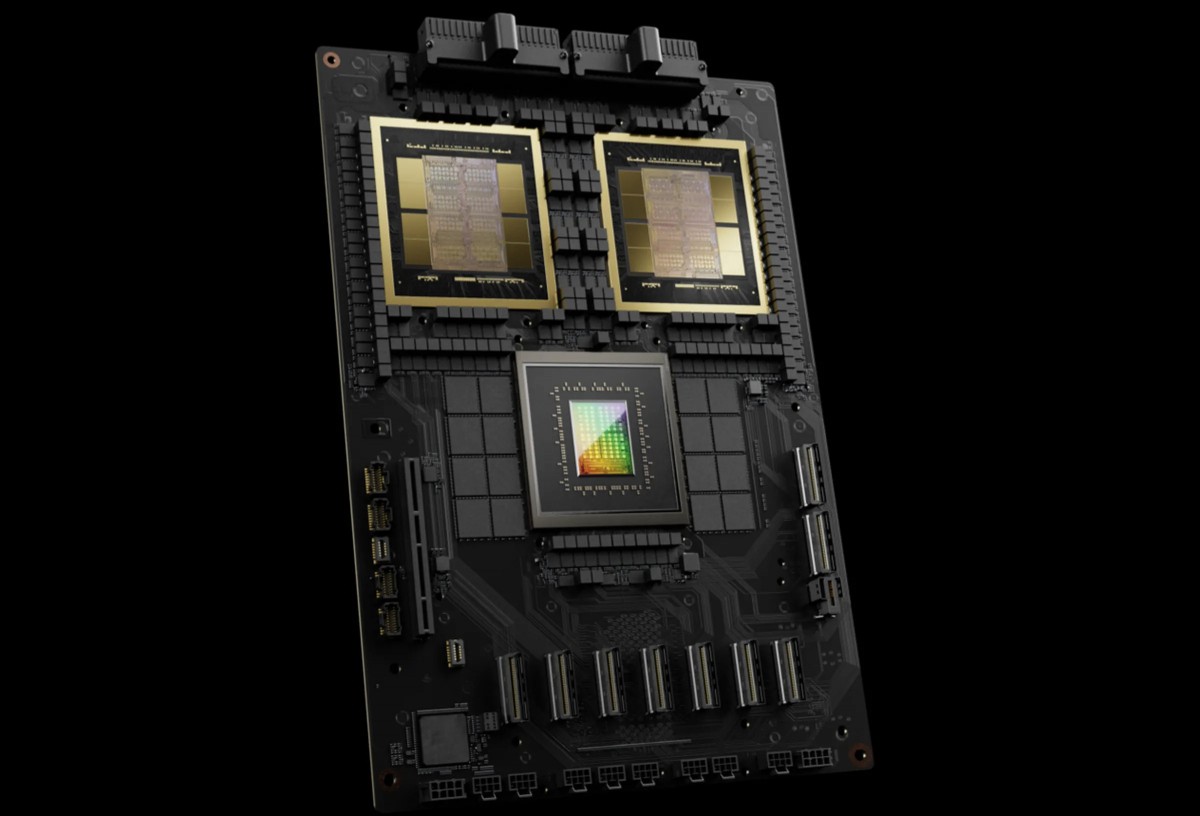

NVIDIA H200

Massiv minneskapacitet och bandbredd

- 3X training performance vs DGX H100

- 15X inference performance vs DGX H100 (per GPU comparison)

- 72 petaFLOPS training / 144 petaFLOPS inference per system

Particularly dominant for real-time LLM inference: 58 output tokens/sec/GPU vs 3.5 for H100 - Particularly dominant for real-time LLM inference: 58 output tokens/sec/GPU vs 3.5 for H100

Överlägsen AI-prestanda

- 1.4TB total GPU memoryacross 8 GPUs (180GB per GPU)

- 64TB/s memory bandwidth

- This massive memory footprint enables handling the largest enterprise AI workloads, including trillion-parameter models and multi-modal applications that would struggle on previous generations

Förbättrad beräkningskraft

Med upp till 30 % fler CUDA-kärnor och förbättrad Tensor Core-teknik ger H200 en betydande prestandaökning jämfört med H100, vilket möjliggör snabbare träningstider och effektivare AI-modellutveckling i olika applikationer.

- Data movement between systems

- Infrastructure complexity and cost

- Time-to-production for AI models

- Operational overhead

Användningsfall

Stor modellinferens

Kör massiva modeller med förutsägbar latens. Optimera för genomströmning, batchstorlek och prestanda per watt.

Generativa AI-applikationer för text, bild och ljud.

Skala maskininlärningsinfrastruktur i takt med att kundbasen växer.