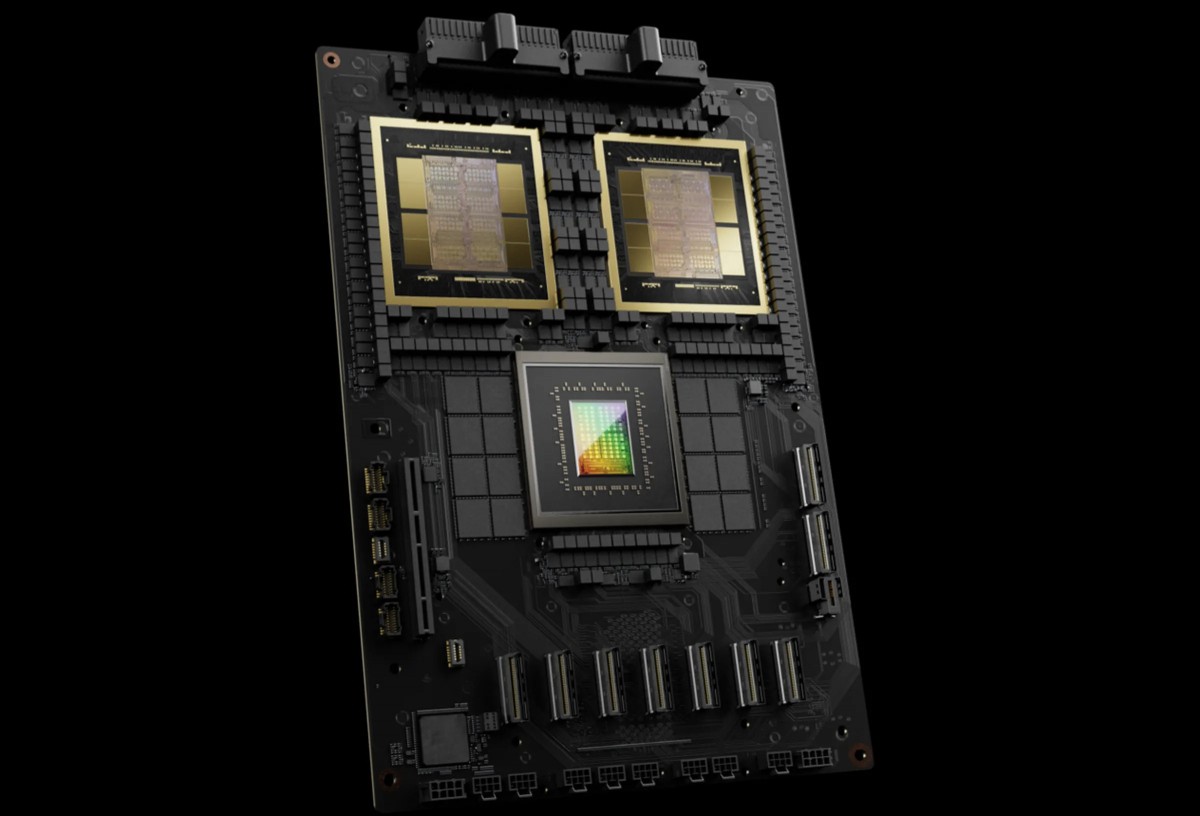

NVIDIA H200

Gran capacidad de memoria y ancho de banda

- 3X training performance vs DGX H100

- 15X inference performance vs DGX H100 (per GPU comparison)

- 72 petaFLOPS training / 144 petaFLOPS inference per system

Particularly dominant for real-time LLM inference: 58 output tokens/sec/GPU vs 3.5 for H100 - Particularly dominant for real-time LLM inference: 58 output tokens/sec/GPU vs 3.5 for H100

Rendimiento superior de IA

- 1.4TB total GPU memoryacross 8 GPUs (180GB per GPU)

- 64TB/s memory bandwidth

- This massive memory footprint enables handling the largest enterprise AI workloads, including trillion-parameter models and multi-modal applications that would struggle on previous generations

Potencia de cálculo mejorada

Con hasta un 30 % más de núcleos CUDA y una tecnología Tensor Core mejorada, la H200 ofrece un aumento sustancial del rendimiento en comparación con la H100, lo que permite tiempos de entrenamiento más rápidos y un desarrollo más eficiente de modelos de IA en diversas aplicaciones.

- Data movement between systems

- Infrastructure complexity and cost

- Time-to-production for AI models

- Operational overhead

Casos de uso

Inferencia de modelos grandes

Ejecute modelos masivos con una latencia predecible. Optimice el rendimiento, el tamaño de los lotes y el rendimiento por vatio.

Aplicaciones de IA generativas para texto, imágenes y audio.

Escalar la infraestructura de aprendizaje automático a medida que crece su base de clientes.