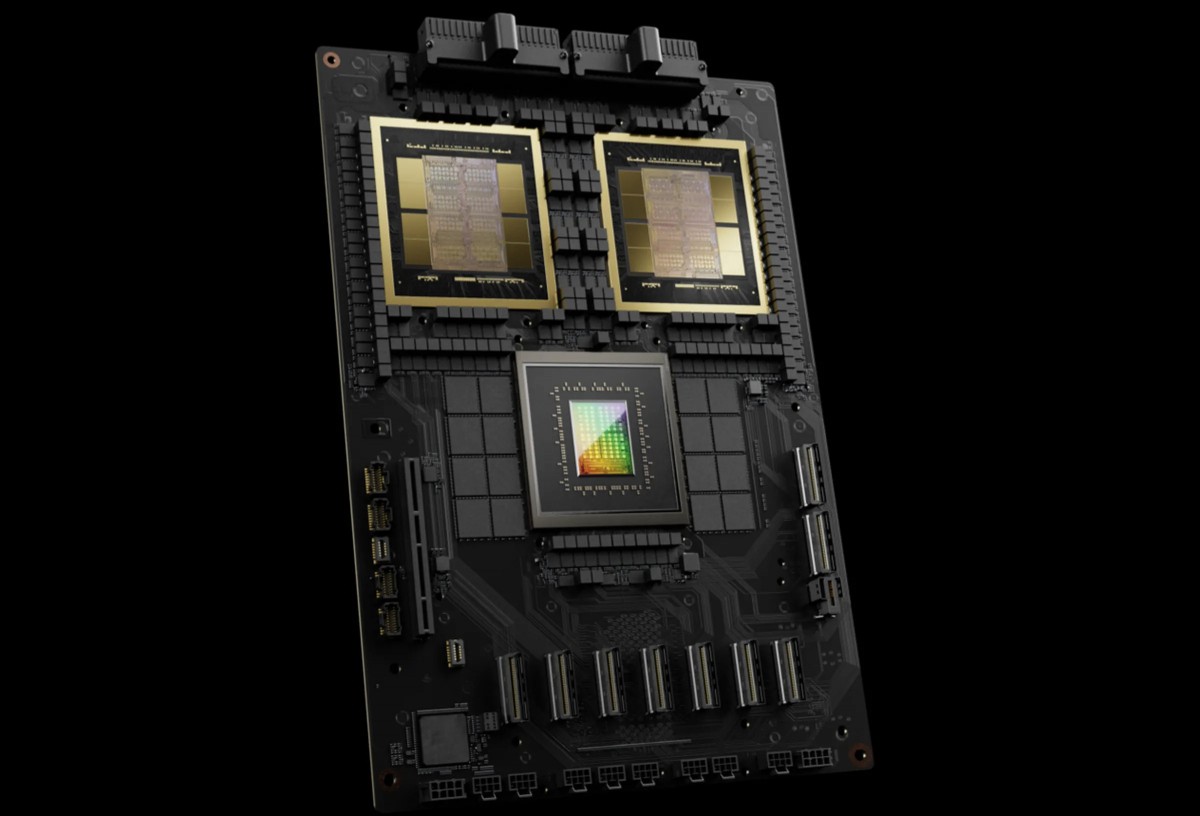

NVIDIA H200

Capacité de mémoire et bande passante massives

- 3X training performance vs DGX H100

- 15X inference performance vs DGX H100 (per GPU comparison)

- 72 petaFLOPS training / 144 petaFLOPS inference per system

Particularly dominant for real-time LLM inference: 58 output tokens/sec/GPU vs 3.5 for H100 - Particularly dominant for real-time LLM inference: 58 output tokens/sec/GPU vs 3.5 for H100

Performance d'IA supérieure

- 1.4TB total GPU memoryacross 8 GPUs (180GB per GPU)

- 64TB/s memory bandwidth

- This massive memory footprint enables handling the largest enterprise AI workloads, including trillion-parameter models and multi-modal applications that would struggle on previous generations

Puissance de calcul améliorée

Avec jusqu'à 30 % de cœurs CUDA en plus et une technologie Tensor Core améliorée, le H200 offre une augmentation substantielle des performances par rapport au H100, permettant des temps d'entraînement plus rapides et un développement de modèles d'IA plus efficace dans diverses applications.

- Data movement between systems

- Infrastructure complexity and cost

- Time-to-production for AI models

- Operational overhead

Cas d'utilisation

Inférence de grands modèles

Exécutez des modèles volumineux avec une latence prévisible. Optimisez le débit, la taille des lots et les performances par watt.

Applications d'IA génératives pour le texte, l'image et l'audio.

Adaptation de l'infrastructure ML à mesure que votre clientèle s'agrandit.